英伟达推出第 8 代 TensorRT。被称为 TensorRT 8 的 SDK 的最新版本带来了一系列更新和进步,使开发人员和企业能够优化和部署他们的深度学习工作流和产品在网络上。

在部署和商业使用中,深度学习模型的推理时间可能会产生瓶颈,尤其是对于 BERT 和 GPT-3 等大型转换器模型。为了缓解此类问题,开发人员采取减少模型参数/大小的方法。但这会导致缩小模型的准确性和质量下降。

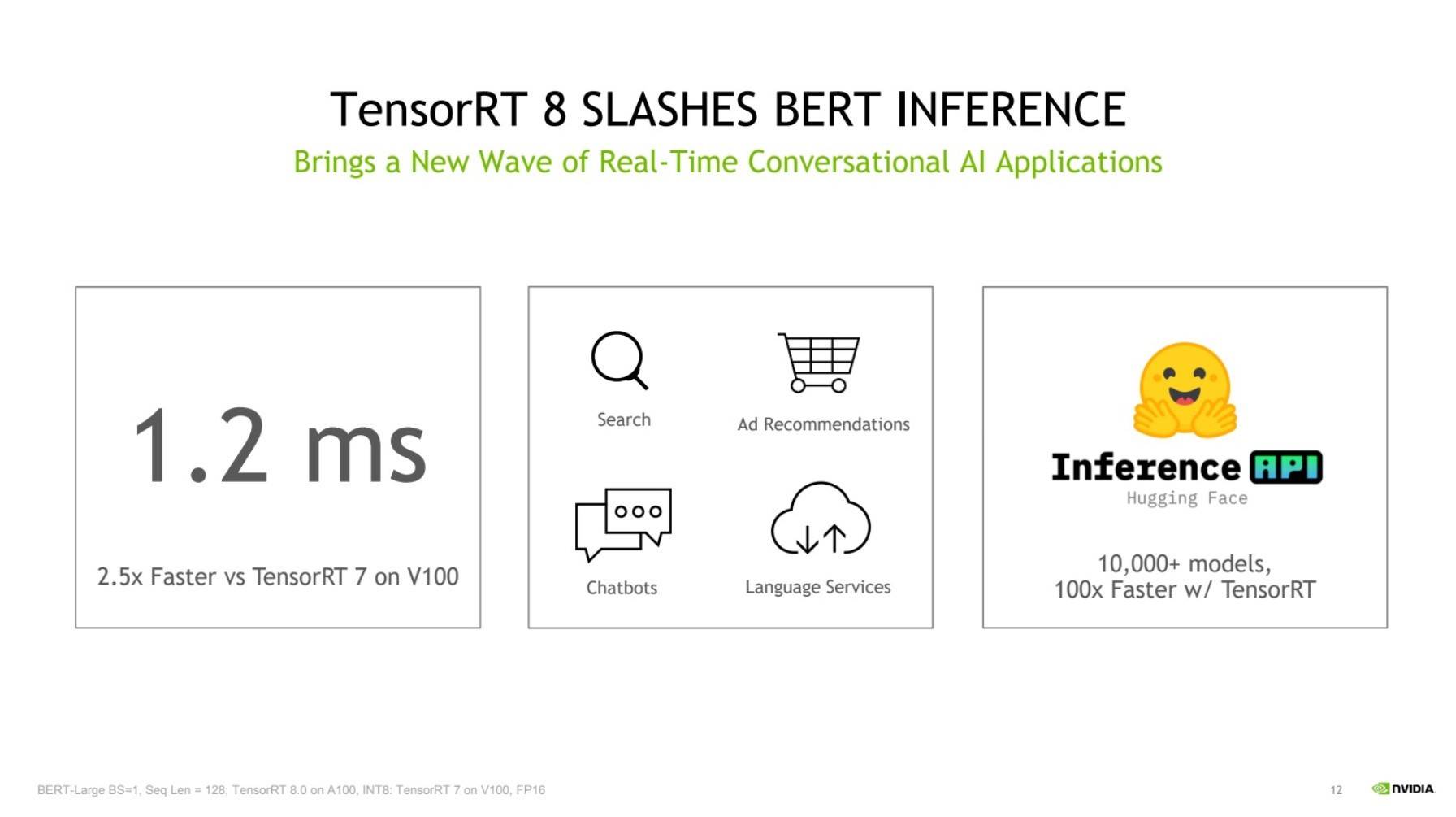

使用TensorRT 8,业界首创,英伟达BERT-Large 的推理时间为 1.2 毫秒,这是当今最常用的语言模型之一。与上一代TensorRT相比,1.2 毫秒的推理时间在Nvidia 的V100 GPU上快了 2.5 倍。TensorRT 8 创纪录的推理时间应该允许企业使用此类语言模型的更大模型,而不必过多担心计算能力和推理时间。

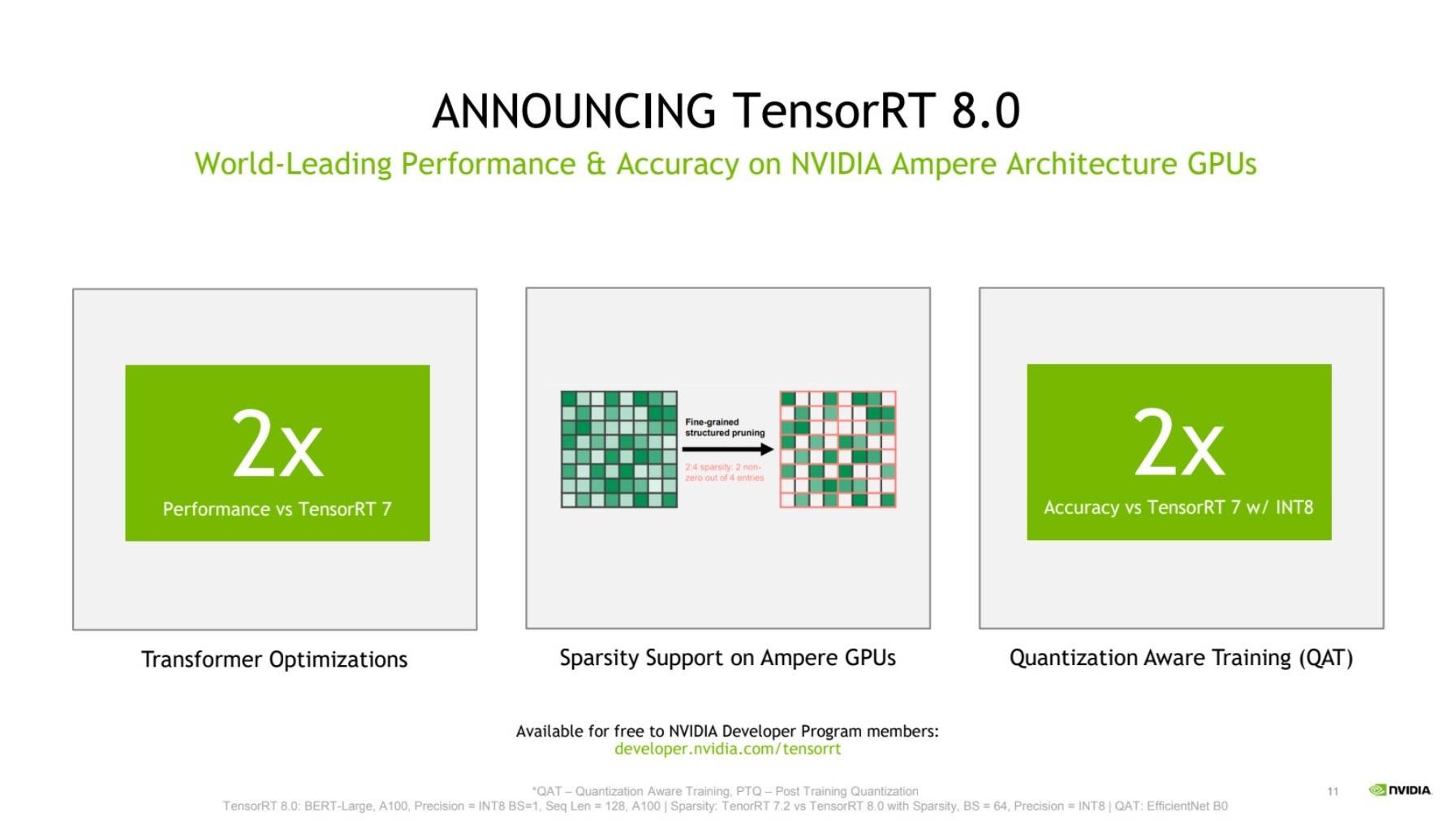

这种快速推理速度的核心在于两个关键的进步。首先,TensorRT 8 利用称为稀疏性的性能技术,通过减少计算操作来加速神经网络推理。Nvidia 的 Ampere 架构支持的稀疏性侧重于神经网络隐藏层中的非零条目,本质上是修剪不影响张量流经网络的条目。这减少了在前向传递中计算答案所需的操作数量,从而在部署期间实现快速推理时间。

第二种技术被称为量化感知训练 (QAT),它允许开发人员使用经过训练的模型以 INT8 精度运行推理而不会损失准确性。与通常用于训练和/或部署的 INT32 和 INT16 精度相比,INT8 通过降低数字的精度来提供更快的计算,从而减少张量核心的计算和存储开销。

“人工智能模型的复杂程度呈指数级增长,全球对使用人工智能的实时应用程序的需求正在激增。这使得企业必须部署最先进的推理解决方案,”英伟达开发人员计划副总裁 Greg Estes 说. “最新版本的 TensorRT 引入了新功能,使公司能够以前所未有的质量和响应能力向客户提供对话式 AI 应用程序。”